Mario Romero.- La decisión de Apple de implementar, por ahora en EE.UU, un scanneo en las cuentas de usuarios de iPhones, Photos, iCloud o iMessages en búsqueda de imágenes de menores abusados sexualmente, (Child Sexual Abuse Material (CSAM) la cual ha recibido criticas, desde comentarios tibios, hasta la postura de organizaciones de DD.HH, como la opinión de Edward Snowden, uno de los que más sabe de espionajes cibernéticos y truculencias de su gobierno, en cuanto a privacidad se refiere y en su cuenta de Twitter no ha quedado ajeno al tema.

Quizás en muchos países como Chile, vemos muy lejanas medidas de este tipo, pero estamos claro que la pedofilia es una lamentable realidad en todo el mundo, y el abuso sexual y la pornografía infantil, son temas transversales en sociedades actuales, pero quizás la forma de cómo se afronta, puede parecernos demasiado invasiva, sobretodo si se trata de una compañía como Apple, que ha luchado por el tema de la privacidad al punto de enfrentarse hasta con el FBI.

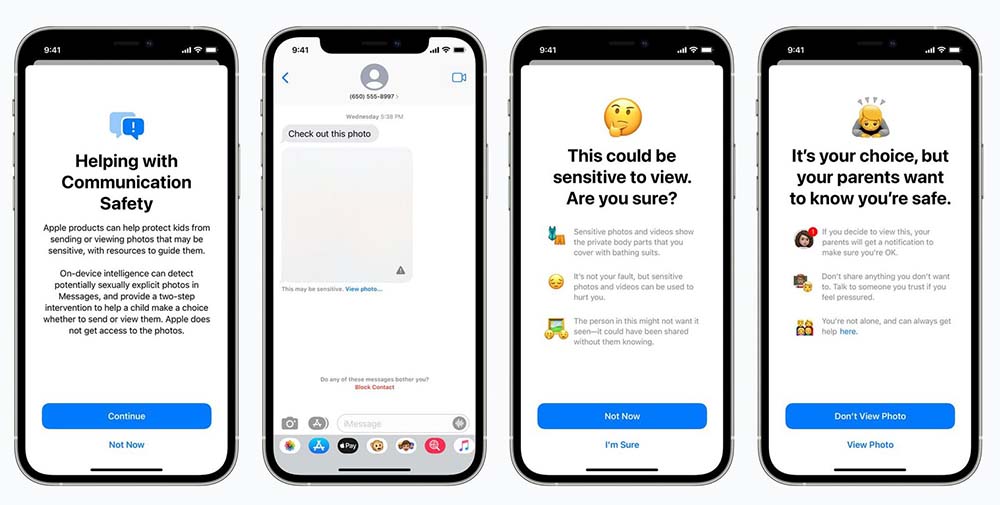

Imagen oficial de Apple

LO QUE DICE APPLE Y CÓMO FUNCIONA EL PROCESO

Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de comparación en el dispositivo para esa imagen con el conjunto ilegible de hashes CSAM conocidos. Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjuntos privados, que determina si hay una coincidencia sin revelar el resultado.

La intersección de conjuntos privados (Private set intersection (PSI) permite a Apple saber si un hash de imagen coincide con los hash de imagen CSAM conocidos, sin aprender nada sobre los hash de imagen que no coinciden y la Private set intersection (PSI) también evita que el usuario sepa si hubo una coincidencia.

LA REACCIÓN

Al respecto, Snowden se refiere en términos bastante críticos respecto de que si Apple pueden escanear en busca de pornografía infantil hoy, pueden escanear en busca de cualquier cosa mañana.. pero si al menos el exfuncionario de la CIA, admite que Apple «tiene buenas intenciones» peor quizás no están equilibradas.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Por su parte, la Electronic Frontier Foundation (EFF), un respetable grupo internacional de derechos digitales sin fines de lucro, ha emitido una amplia condena al movimiento de Apple de escanear las bibliotecas y mensajes de iCloud de los usuarios, diciendo que está extremadamente «decepcionado» de que un «campeón del cifrado de extremo a extremo» está emprendiendo un «cambio radical para los usuarios que han confiado en el liderazgo de la empresa en materia de privacidad y seguridad».

Habrá ahora que ver cómo Apple responde con argumentos y racionalidad un tema que es por naturaleza delicada, pues la idea en la base es bienvenida si se trata de reducir las altas tasas de pornografía infantil y todos sus horribles derivados, pero quizás podría en ese afán, dejar abierta la puerta para que se le de un uso indebido.

Por lo pronto, puede ser una sobre reacción en contra de la medida, por el hecho de tratarse de Apple.

EL TEMA NO ES NUEVO

Pese a la polémica que se ha levantado en contra de la decisión de Apple, hay que tener en cuenta que Google, por ejemplo, lleva utilizando el hashing para identificar pornografía infantildesde el año 2008! y Microsoft desarrolló la conocida base de datos PhotoDNA que emplea el hashing en 2009, utilizándose en todos sus servicios en la nube. También se encuentra en uso por Twitter, Gmail, Facebook, Adobe, Reddit y Discord, incluyendo la propia National Center for Missing & Exploited Children’s (NCMEC).

Apple lleva desde al menos 2019 analizando en la nube las fotos subidas a iCloud con las mismas técnicas, solo que ahora decidió ir más allá, profundizarlo con nuevas herramientas, Machine Learning y claramente, con un problema de cómo comunicarlo de buena forma.