Luego de las repercusiones que ha tenido la implementación del scanneo de imágenes por parte de Apple a los usuarios de iCloud, en búsqueda de fotos con eventuales abusos sexuales infantiles o actos de pedofilia, y que un reporte reciente publicado por el The New York Times, da cuenta que las empresas de tecnología reportaron más de 45 millones de fotos y videos en línea de niños víctimas de abuso sexual, más del doble de lo que encontraron el año anterior, está claro que el tema debe abordarse, pero probablemente Apple no lo ha sabido comunicar adecuadamente.

Más aún cuando se genera un quiebre interno, éste se filtra y Reuters hace su trabajo difundiendo las posturas al interior de la compañía, todo este escenario parece haber generado un «acuse de recibo» y ha salido al paso nuevamente respecto al tema, en un documento donde (nuevamente) sale a aclarar el proceso.

EL CAMBIO DE APPLE SOBRE EL SCANNEO DE IMÁGENES

Apple, anunció que solamente buscará imágenes marcadas por cámaras ya denunciadas, como una reacción ante la creciente ola de críticas sobre el sistema propuesto para detectar imágenes de abuso infantil y la compañía declaró que, solamente rastreará imágenes marcadas varias veces por cámaras determinadas.

Este es uno de los cambios que realizará la empresa para calmar a los defensores de la privacidad y bajar el tono de las críticas

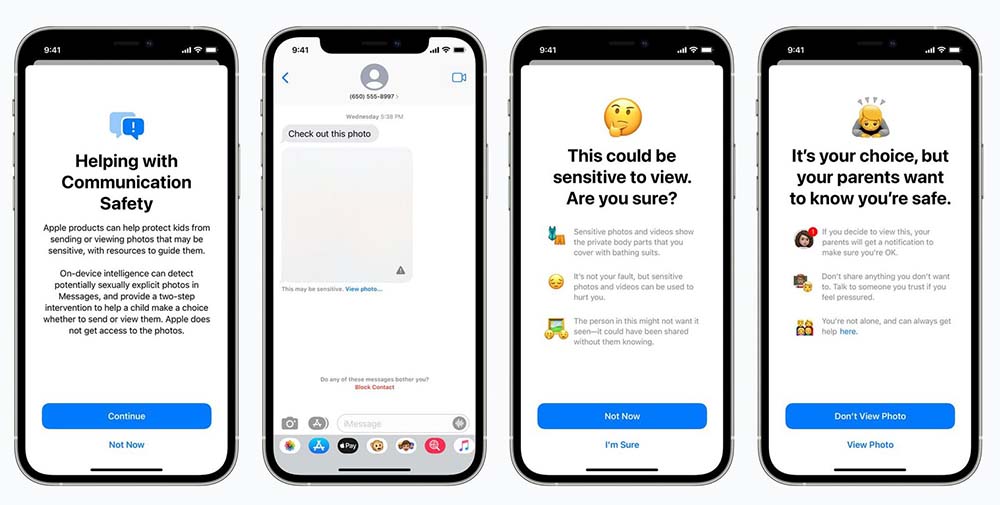

CÓMO OPERA AHORA EL CRITERIO?

Luego de que se negaran al principio a especificar cuántas serían las imágenes marcadas como coincidentes en un dispositivo, ya sea computadora o iPhone, Apple haría una revisión humana y desde allí se genere posiblemente un informe para las autoridades.

Apple dijo también que, para las autoridades sería más fácil tener certeza de que la lista de los identificadores de fotografías que se rastrean en un iPhone, llegue a ser igual que las listas en el resto de los teléfonos actuales, esto con la finalidad de disminuir las preocupaciones acerca de que el nuevo sistema pudiera utilizarse para señalar a personas de forma sesgada.

Del mismo modo, la compañía reconoce que tuvo un mal manejo comunicacional sobre el nuevo sistema y que por esa razón se generó una reacción por parte de grupos de influencia en políticas tecnológicas que incluso alertó a los propios empleados de Apple, donde se generó un debate y alta preocupación por que la empresa pudiera poner en riesgo su propia reputación de proteger la privacidad de sus usuarios,

Apple señaló que, el proyecto todavía se encuentra en desarrollo y que aún pueden hacerse otros cambios y la sucesiva serie de explicaciones, cada una con más detalles que hacen que el plan parezca menos hostil a la privacidad, convenció a algunos de los críticos de la compañía de que sus voces estaban forzando un cambio real.

Un representante de la empresa dijo que Apple había terminado con el trato con NCMEC (Centro Nacional para Niños Desaparecidos y Explotados) y que solo tomaran en consideración los criterios del CSAM (Centro Nacional para Niños Explotados y Desaparecidos)

ASI FUNCIONABA

La herramienta de Apple original pretendía funciar para aquellos usuarios que tengan sincronizadas sus imágenes con iCloud y el dispositivo comparará las fotografías locales, antes de ser volcadas en la nube, con una base de datos CSAM (material de abuso infantil, por sus siglas en inglés)

Si encuentra las suficientes coincidencias, entrarán en juego los moderadores de Apple que, en caso de detectar la presencia de contenido de este tipo, deshabilitarán la cuenta y avisarán a las autoridades pertinentes.

Este sistema de la CSAM no es una idea nueva y ha sido utilizado por empresas como Facebook, Twitter o Reddit, utilizado a menudo una herramienta llamada PhotoDNA, creada por Microsoft para encontrar y eliminar imágenes conocidas de explotación infantil.